AIは人間レベルの認知を自発的に形成できるのか?中国チームの最新研究が初めて実証

人工知能(AI)は人間と同じように物事を認知し、理解できるのだろうか。中国の科学者チームは行動実験と神経イメージング分析を組み合わせた研究により初めて、AI技術に基づくマルチモーダル大規模言語モデルが、人間に非常に類似した物体概念表象システムを自発的に形成することを実証した。つまり、AIが人間レベルの認知を自発的に形成できるのだ。中国新聞網が伝えた。

同研究は中国科学院自動化研究所(以下「自動化所」)神経計算とブレイン・マシン・インタフェース研究チームおよび中国科学院脳科学・スマート技術卓越イノベーションセンターのチームなどが共同で実施した。関連成果論文は9日、国際的専門学術誌「Nature Machine Intelligence」にオンライン掲載された。これはAI認知科学の新たな道を開いただけでなく、人間のような認知構造を持つAIシステムを構築するための理論的枠組みも提供している。

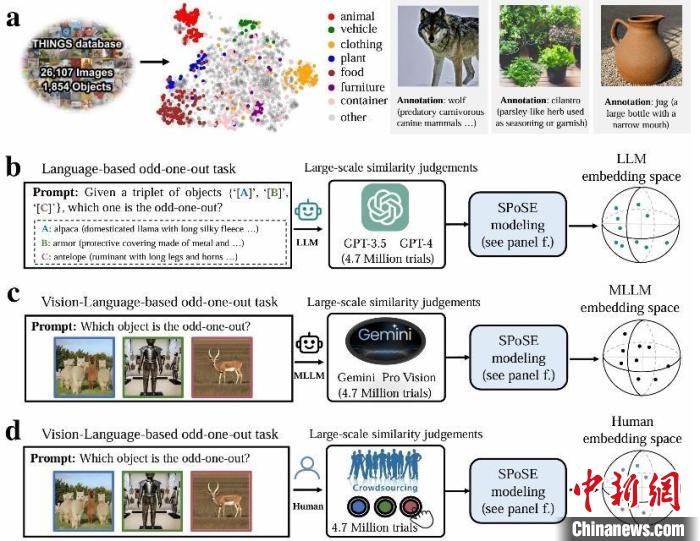

同研究の実験パラダイムのイメージ図。画像提供:自動化所

論文の筆頭著者で自動化所の杜長徳副研究員は、「人類は自然界の物体を概念化する能力を持ち、この認知能力は長年にわたり人類知能の中核とされてきた。例えば、人々が『犬』や『自動車』あるいは『リンゴ』などを見たとき、その物理的特徴(サイズ、色、形など)を識別できるだけでなく、その機能、感情的価値、文化的意味まで理解できる。このような多次元的な概念表象が人類の認知基盤を形成している」と説明した。

近年、ChatGPTなどの大規模言語モデルの急速な発展に伴い、これらの大規模言語モデルが言語やマルチモーダルデータから人間に類似した物体概念表象を形成できるかどうかという根本的な問題も浮上し、大きな注目を集めている。

論文の連絡著者で自動化所の何暉光研究員は、「従来のAI研究は物体認識の精度ばかりに注目し、モデルが物体の意味を本当に理解しているかどうかにはほとんど触れてこなかった。現在のAIは猫や犬の画像を識別できるが、それは人間の理解との本質的な違いについての解明が待たれる」と指摘した。

研究チームは同研究において、認知神経科学の古典的理論をもとに、計算モデリング、行動実験、脳科学を結びつけた革新的なパラダイムを設計した。チームは認知心理学における古典的な「三者択一タスク」を採用し、大規模言語モデルと人間に対して、物体概念の三元組(1854種類の日常概念の任意の組み合わせ)から最も類似していない選択肢を選ばせた。470万回の行動判断データを分析することで、研究チームは初めてAIモデルの「概念マップ」を構築した。

研究チームはこれを踏まえた上で、大量の大規模言語モデル行動データから66の「心的次元」を抽出し、それぞれに意味ラベルを付与した。研究の結果、これらの次元は非常に高い説明可能性を持ち、さらに、脳のカテゴリー選択領域(顔、風景、身体などの情報を処理する領域)の神経活動パターンと顕著に相関していることが明らかになった。

研究チームはさらに、複数のモデルの行動選択パターンにおける人間との一致性を比較した結果、マルチモーダル大規模言語モデルは一致性の面でより優れている。この研究ではさらに、人間が意思決定を行う際に視覚的特徴と意味情報を結びつけて判断する傾向があるのに対し、大規模言語モデルは意味ラベルと抽象的概念に依存する傾向が強いことが明らかになった。

何氏は、「機械認識から機械理解への飛躍を実現する同研究では、大規模言語モデルが『ランダムなオウム』ではなく、人間と類似した現実世界の概念に対する理解が内部に存在することが分かった。その中核的な発見は、AIの心的次元が人間と異なる道を歩んでいても同じ目的地にたどり着くことだ」と述べた。(編集YF)

「人民網日本語版」2025年6月11日

QRコードを読み取る

QRコードを読み取る